从序列建模到Transformer的进化:揭秘现代AI的核心引擎

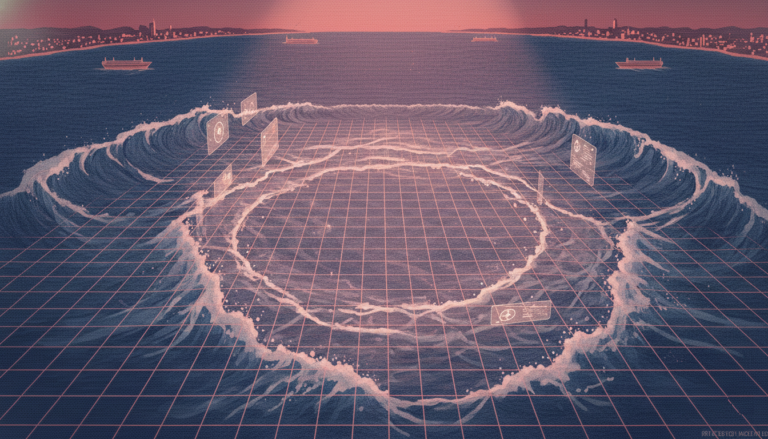

在本系列的第二篇中,我们继续探讨Transformer模型如何彻底革新序列建模。上一篇文章介绍了循环神经网络(RNN)的原理与局限,尤其是其在处理长序列时梯度消失或爆炸的问题。而Transformer的核心突破,正是通过自注意力机制(Self-Attention)解决了这些瓶颈。 自注意力机制的核心思想是:每个词不仅能关注自身的上下文,还能直接“扫描”整个句子,判断哪些词对理解当前词最为关键。例如,在句子“那只老鼠突然僵住,然后惊恐地冲过地板,它的身体颤抖着,猫猛地扑向它”中,我们能立刻理解“它”指代的是“老鼠”,这依赖于对“惊恐”这一语境的判断。自注意力机制正是通过三个向量实现这一过程:查询(Query)表示当前词在“寻找什么”,键(Key)表示其他词能“提供什么”,值(Value)则包含该词的语义内容。 模型通过计算查询与键的点积来衡量相关性,再进行缩放(防止维度过高导致数值过大),并经由Softmax归一化为注意力权重。最后,用这些权重对值向量加权求和,生成当前词的新表示。这一过程高效且可并行计算,避免了RNN中逐个时间步处理的限制。 随着模型层数加深,注意力机制学习到的特征也从低级走向高级。在浅层,模型捕捉语法结构,如主谓关系(“猫”与“扑”)、动宾关系(“老鼠”与“扑”);而在深层,模型开始理解语义连贯性和指代关系,例如识别“它”指代“老鼠”,实现核心指代消解。 Transformer架构完全基于注意力机制构建,摒弃了RNN或CNN的递归结构。其编码器块(Encoder Block)和解码器块(Decoder Block)通过多头注意力与前馈网络组成,实现全局依赖建模。尽管注意力机制并非首次提出,但Transformer是首个完全依赖自注意力、无需时间步递归的模型,专为机器翻译设计,实现了前所未有的并行训练效率。 训练目标采用“下一个词预测”任务,通过交叉熵损失反向传播优化参数。由于所有位置可同时处理,训练速度远超RNN。更关键的是,Transformer具备强大的迁移学习能力:预训练后只需少量微调即可适应下游任务,且模型规模越大,性能提升越明显。 Transformer的成功源于四大优势:无梯度瓶颈、支持并行训练、可迁移性强、高度可扩展。然而挑战仍存:推理阶段仍需逐词生成,存在误差累积问题;默认贪婪解码导致生成结果单一;多样性受限,需依赖温度采样等策略缓解。 未来,如何提升生成的逻辑性、可回溯性与多样性,仍是大模型发展的核心方向。