AI实验室指控LM Arena帮助顶级公司操控基准测试结果

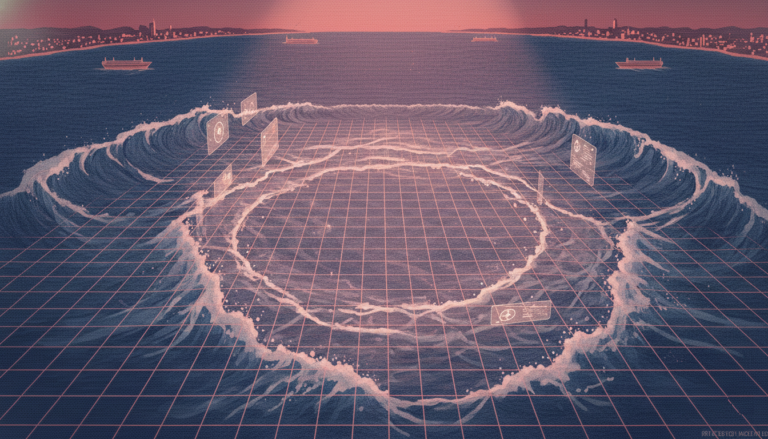

一篇新论文揭露了LM Arena(Chatbot Arena背后的组织)帮助一些顶级AI公司提高排行榜得分的问题。这篇由Cohere、斯坦福大学、麻省理工学院和Ai2联合发布的论文指出,LM Arena允许Meta、OpenAI、Google和Amazon等领先公司私下测试多个模型变体,然后不公布表现较差的模型分数,从而让他们更容易登上排行榜的顶端。这一特权并非所有公司都能享受,论文作者认为这是一种不公平的竞争行为。 Cohere的AI研究副总裁Sara Hooker在接受TechCrunch采访时说:“只有少数几家公司被告知有私下测试的机会,而且一些公司获得的私测机会远多于其他公司。” 这种做法被称为“游戏化”操作。 Chatbot Arena成立于2023年,是一个由加州大学伯克利分校发起的学术项目,现已成为评估AI模型性能的重要平台。它的运作方式是将两个不同AI模型的答案放在一起比较,让用户选择更好的一个答案,用户的投票逐渐积累成为模型的得分,影响其在排行榜上的位置。 论文作者从2024年11月开始调查,发现在五个月内,Chatbot Arena共进行了超过280万次“战斗”。他们发现证据表明,LM Arena允许某些公司如Meta、OpenAI和Google的模型在更多“战斗”中出现,从而收集更多的数据。这种更高的采样率使这些公司在Arena Hard基准测试中的表现提高了112%。然而,LM Arena表示,Arena Hard的表现并不能直接反映Chatbot Arena的表现。 具体来说,论文提到Meta在2024年初至3月期间,私下测试了27个Llama 4模型变体,最终只公开了一个得分较高的模型。这引发了其他参与者的质疑,认为这种做法有失公平。 论文作者强调,他们的研究方法依赖于AI模型的自我识别,多次询问模型的来源并根据其回答进行分类,但这种方法并不完全可靠。尽管如此,当研究人员与LM Arena共享初步发现时,后者并未提出异议。 对此,LM Arena在X平台(前Twitter)发表声明,否认研究中的许多指控,称其自2024年3月以来已经公布了预先测试的信息,并认为显示未公开模型的得分没有意义,因为这些模型无法被AI社区验证。然而,LM Arena也表示将采纳调整采样率的建议,开发新的算法,确保所有模型在“战斗”中的出现次数相同。 论文还提议,LM Arena应设立明确透明的私测次数限制,并公开这些测试的分数。此外,几个星期前,Meta因为在其Llama 4模型发布前通过优化“对话能力”获取高分而受到质疑。当时,LM Arena批评Meta应更加透明地处理基准测试。 最近,LM Arena宣布正在成立一家公司并计划筹集资本,这进一步增加了外界对其真实性的质疑。业内人士认为,这次曝光将进一步促使LM Arena提高透明度,确保其评估体系的公正性,避免受商业利益的影响。 Cohere是一家致力于自然语言处理的AI公司,其研究团队长期关注AI行业的公正性和透明度问题。该公司的研究成果引起了广泛的讨论,可能推动行业标准和评估机制的改进。