Command Palette

Search for a command to run...

DeepPlanning:基于可验证约束的长时域Agent规划基准测试

DeepPlanning:基于可验证约束的长时域Agent规划基准测试

Yinger Zhang Shutong Jiang Renhao Li Jianhong Tu Yang Su Lianghao Deng Xudong Guo Chenxu Lv Junyang Lin

摘要

尽管智能体评估已逐渐转向长周期任务,但大多数现有基准测试仍侧重于局部的、逐步的推理,而非需要真正规划能力的全局约束优化(如时间与预算限制)。与此同时,现有的大语言模型(LLM)规划基准测试在很大程度上未能体现现实场景中典型的主动信息获取行为以及细粒度的局部约束。为解决这一问题,我们提出了 DeepPlanning——一个面向实际长周期智能体规划的具有挑战性的基准测试。该基准包含多日旅行规划和多商品购物等任务,要求智能体具备主动获取信息、进行局部约束推理以及实现全局约束优化的能力。在 DeepPlanning 上的评估表明,即使是最先进的智能体化大语言模型在处理这些问题时仍表现不佳,凸显了可靠显式推理模式与并行工具使用在实现更优效果-效率权衡中的重要性。错误分析进一步揭示了提升智能体化大语言模型在长周期规划中表现的潜在改进方向。我们已开源代码与数据,以支持后续研究。

一句话总结

阿里巴巴集团的通义团队推出了DEEPPLANNING,这是一个用于评估大语言模型在需要主动信息收集和全局约束优化的真实世界长时程规划任务中的表现的基准测试,揭示了当前模型的局限性,并强调了显式推理和并行工具使用的必要性。

主要贡献

- 我们引入了DEEPPLANNING,这是一个新基准测试,包含多日旅行和多商品购物任务,要求主动收集信息、处理局部约束,并在时间和预算限制下实现全局优化,弥补了现有大语言模型代理评估的空白。

- 对前沿代理型大语言模型的评估显示,它们在长时程规划中普遍存在困难,表明显式推理模式和并行工具使用对于在复杂约束场景中提升效果-效率权衡至关重要。

- 通过错误分析,我们识别出关键失败模式——如遗漏工具调用、未检测到隐式约束、缺乏全局一致性检查——并提出了增强代理型大语言模型以应对扩展规划任务的可行方向。

引言

作者利用真实世界的多日旅行和多商品购物场景评估大语言模型代理的长时程规划能力,其中必须在相互依赖的步骤中优化全局约束(如时间预算和累计成本)。先前的基准测试往往侧重于局部步骤级推理或过度简化的全局约束,未能捕捉实际环境中典型的主动信息收集和细粒度约束处理需求。其主要贡献是DEEPPLANNING,这是一个新基准测试,强制实施可验证的多级约束,揭示当前代理的关键缺陷——特别是它们无法可靠回溯、维持全局一致性或并行使用工具——同时强调显式推理和工具编排对于提升效果和效率至关重要。

数据集

作者使用DeepPlanning,这是一个由两个复杂真实世界规划领域组成的基准测试:旅行规划和购物规划。每个任务运行在由领域特定数据库支持的隔离沙箱中,并通过自定义Python工具包访问,确保可复现性。

-

数据集组成与来源:

- 旅行规划:120个任务(提供中文和英文版本),来源于通过公共API(飞猪、高德、网络搜索)获取的真实世界数据,涵盖中国旅游城市的交通、酒店、景点和餐饮。

- 购物规划:120个仅英文任务,基于合成产品数据构建,包括价格、库存、评分和促销,旨在实现可控复杂度。

-

关键子集详情:

- 旅行规划:使用7个子数据库和9个API(如query_hotel_info)。任务要求生成多日行程,精确到分钟级调度、分项成本和预算汇总。约束涉及时间、地点和预算耦合。

- 购物规划:使用3个子数据库和15个API(如search_products)。任务要求组装满足用户偏好、尺寸、配送、优惠券和预算的JSON购物车。挑战涉及购物车内的组合优化。

-

数据构建流程:

- 数据库与工具箱设计:构建领域特定数据库和分层API,鼓励多步代理交互。

- 分层任务生成:任务从解决方案反向工程:

- 生成基础骨架(如旅行路线或产品主题)。

- 注入个性化约束(如“预订7点后航班”)和环境约束(如关闭景点或优惠券叠加)。

- 调整数据库条目,确保恰好存在一个最优解。

- 大语言模型将约束转换为自然语言查询。

- 人工质量控制:人类专家验证每个任务的流畅性、清晰度和可解性。

-

模型中的处理与使用:

- 任务基于三个核心代理能力评估:主动信息获取、局部约束推理和全局约束优化。

- 输出格式严格结构化:旅行规划返回分钟级行程及成本分解;购物规划返回包含商品详情和优惠券使用的JSON购物车。

- 评估使用21项评分标准衡量旅行规划中的常识推理,涵盖逻辑一致性、约束满足和预算准确性。

- 不应用裁剪;所有任务均为全范围端到端规划挑战。元数据嵌入工具模式和数据库字段(表3–6),定义API参数和数据结构。

作者未在该数据集上进行训练;它作为评估代理在真实世界约束下规划性能的基准测试。

方法

作者利用分层任务生成框架,将复杂的用户查询分解为旅行和购物领域的结构化规划工作流。架构分为三个连续阶段:基础骨架生成、个性化约束注入和环境约束注入。每个阶段通过整合用户偏好、领域特定规则和实时环境数据逐步完善计划。

在旅行规划模块中,系统首先解析用户的高层次请求——如目的地、日期和预算——并生成初始行程骨架。接着注入个性化约束,如酒店星级或餐饮偏好,映射到特定工具调用如query_hotel_info或recommend_around_restaurants。最后阶段整合环境约束,如航班可用性或景点开放时间,从外部数据库检索。图中所示代理轨迹说明了如何链式调用工具以填充计划,确保所有实体——航班、酒店、景点——均仅来源于工具输出,无虚构。

对于购物规划,框架同样从产品类别和预算导出的基础骨架开始。然后注入个性化约束——如品牌、尺寸或评分阈值——触发通过search_products等工具进行有针对性的产品搜索。环境约束阶段整合用户资料数据,如可用优惠券,并根据定价逻辑评估组合。系统强制执行严格的优惠券应用规则:跨店优惠券适用于整个购物车总额,而同品牌优惠券仅限于单个品牌子总额。仅当每个优惠券的阈值在折扣后满足时才允许叠加,最终选择在预算内产生绝对最低价格的组合。

两个领域的评估模块根据预定义指标评估计划质量。在旅行中,检查常识合规性、成本准确性和行程结构;在购物中,验证产品匹配准确性与真实数据。系统要求所有最终决策基于购物车状态,通过getCart_info验证,确保优惠券使用和商品选择与最终交易上下文一致。所有输出严格源自工具结果,不允许创造性解释或数据伪造。

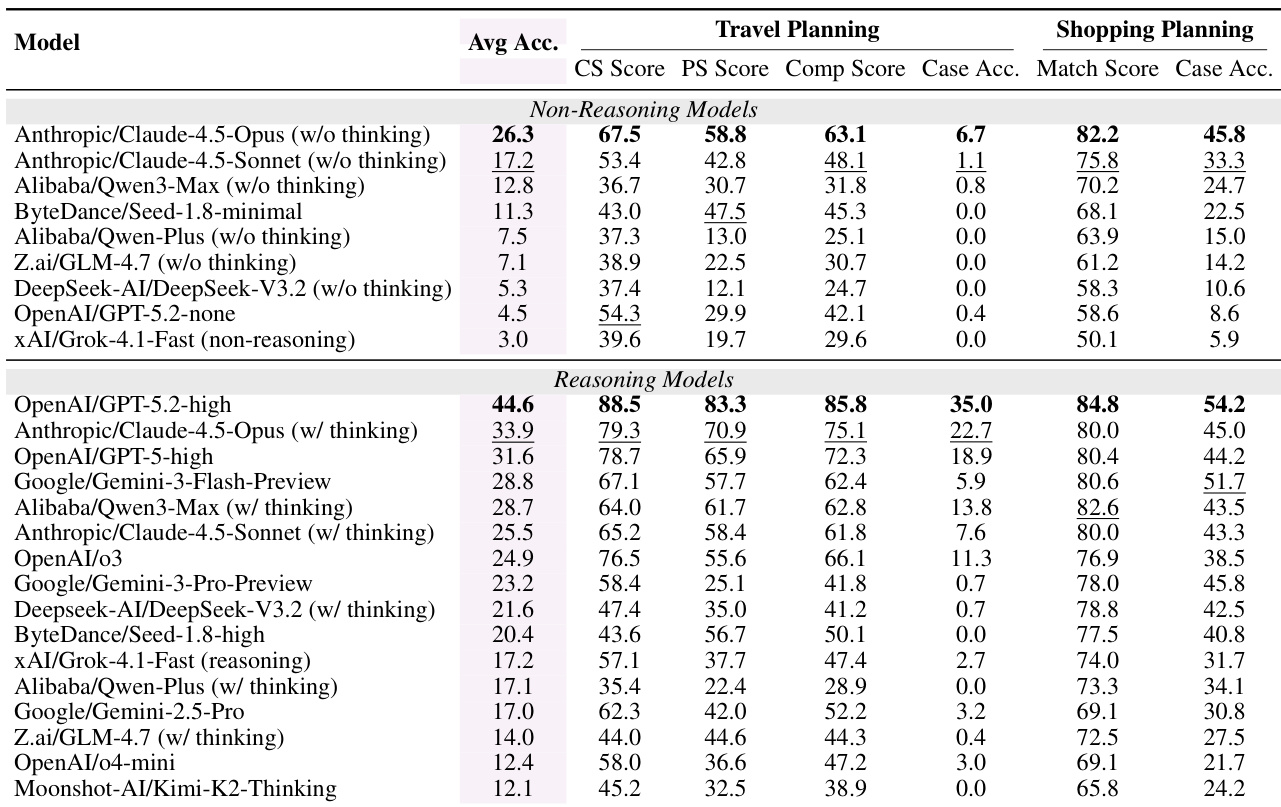

实验

- DeepPlanning 使用基于代码、规则驱动的指标评估大语言模型代理在旅行和购物领域的复杂真实世界规划任务,确保客观性。

- 代理在端到端执行中表现出脆弱性:高约束级别得分常掩盖关键全局失败,导致即使顶级模型的案例级别准确率仍较低。

- 内部推理显著提升性能和效率,减少冗余工具使用并实现更好的成本-性能权衡。

- 随任务复杂度增加性能下降——更长行程或多约束购物任务暴露代理在全局优化和约束传播方面的困难。

- 错误分析揭示三种主导失败模式:信息检索不足或误用、局部约束违反、整合相互依赖决策的系统性崩溃。

- 工具使用与性能相关:更多调用可改善结果,但推理模型以更少交互获得更高分,表明更智能的规划。

- 领域专业化明显——某些模型在一个领域表现优异(如Gemini在购物中),但在另一领域表现不佳,凸显任务特定优势。

- 当前基准测试仅限旅行和购物;合成查询可能无法反映真实用户行为,多轮交互仍未探索。

作者使用基于代码的评估框架评估大语言模型代理在复杂旅行和购物规划任务中的表现,揭示即使顶级模型在组件级别得分高,仍难以实现端到端一致性。结果表明,具备内部推理能力的模型在多约束条件下持续优于无推理模型,特别是在维持全局计划完整性方面。推理带来的性能提升需权衡交互成本,因为更谨慎的规划减少冗余工具使用,但可能增加轮数或需要更结构化的执行。