Command Palette

Search for a command to run...

CL-bench:上下文学习基准

CL-bench:上下文学习基准

摘要

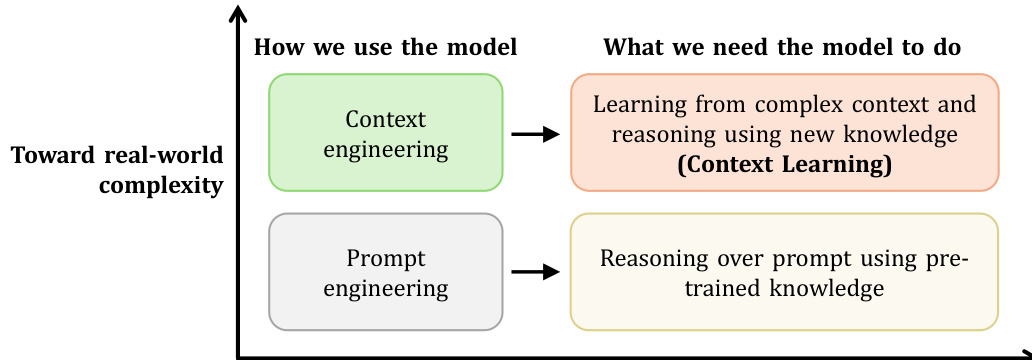

当前的语言模型(LMs)在利用预训练知识对提示词进行推理方面表现出色。然而,现实世界中的任务远为复杂且高度依赖上下文:模型必须从特定任务的上下文中学习,并运用预训练阶段未涵盖的新知识,才能进行推理并完成任务。我们称这种能力为“上下文学习”(context learning),这是人类与生俱来的重要能力,却长期被忽视。为此,我们提出了CL-bench,这是一个真实世界基准测试集,包含500个复杂上下文、1,899个任务以及31,607条验证标准,所有内容均由经验丰富的领域专家精心设计。每个任务均被设计为:解决该任务所需的新信息均包含在对应的上下文中。在CL-bench上完成任务,要求模型能够从上下文中学习,涵盖新领域的专业知识、规则体系、复杂流程,乃至基于实证数据推导出的法律或规律,而这些内容在预训练阶段均未出现。这一要求远超传统的长上下文任务(主要测试信息检索或阅读理解能力),也不同于仅通过指令和示例学习简单任务模式的“上下文学习”任务。我们对十种前沿语言模型的评估显示,模型平均仅能解决17.2%的任务。即便是表现最佳的模型GPT-5.1,也仅能解决23.7%的任务,这表明当前语言模型尚未具备有效的上下文学习能力,而这正是应对现实世界中复杂、依赖上下文任务的关键瓶颈。CL-bench的提出,标志着迈向构建具备这一基础能力的语言模型的重要一步,有助于提升模型的智能水平,并推动其在真实场景中的广泛应用。

一句话总结

腾讯混元团队与复旦大学的研究人员提出 CL-bench,这是一个揭示语言模型在“上下文学习”能力上严重不足的现实世界基准——即从上下文中获取新知识以解决复杂任务的能力。即使 GPT-5.1 也仅能解决 23.7%,凸显了在实际依赖上下文场景中部署语言模型的关键瓶颈。

主要贡献

- 本文指出当前语言模型的一个关键缺陷:无法执行“上下文学习”——即从上下文中学习并应用新的、特定任务的知识,而非仅依赖预训练知识,而这一能力对现实世界中依赖上下文的任务至关重要。

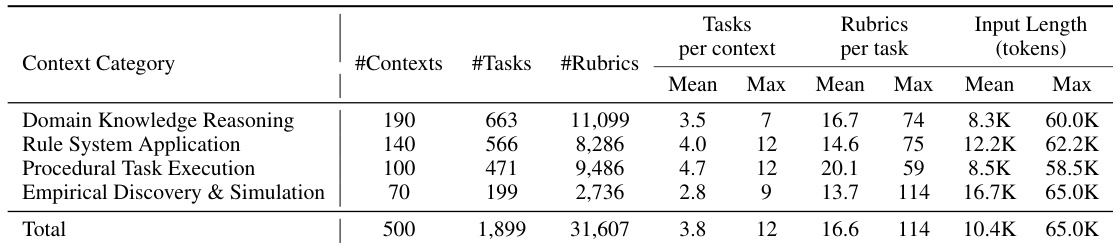

- 为评估该能力,作者引入 CL-bench,一个由领域专家精心构建的基准,包含 500 个复杂上下文、1,899 个任务和 31,607 条验证标准,全部设计为要求模型在无外部检索的情况下从上下文中学习,覆盖规则系统、流程操作和经验发现等领域。

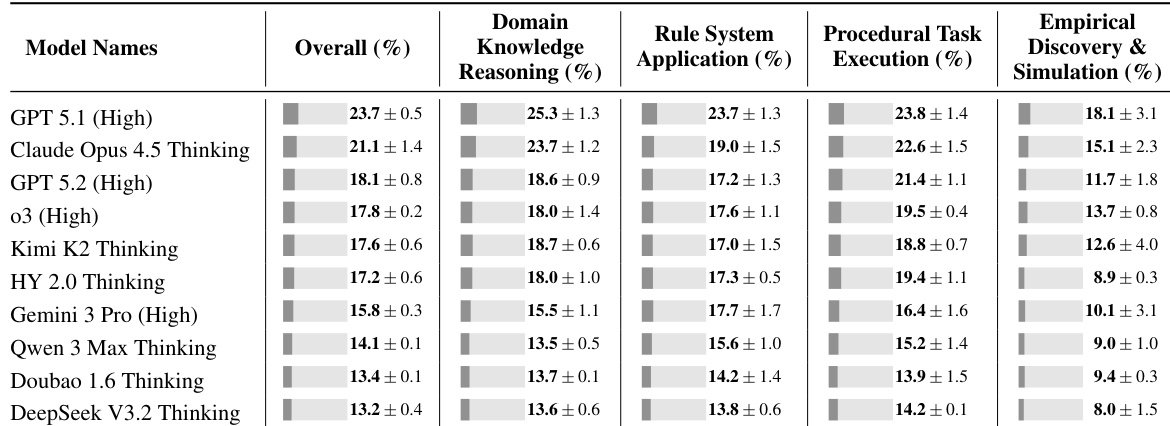

- 对十种前沿语言模型的评估显示严重局限,模型平均仅解决 17.2% 的任务,表现最佳的模型(GPT-5.1)也仅达 23.7%,凸显上下文学习仍是实际部署的根本瓶颈。

引言

作者利用当前语言模型依赖预训练知识与现实世界动态上下文学习需求之间的日益扩大的差距——模型必须从复杂上下文中吸收并应用新的、特定任务的信息。以往的基准多聚焦于检索、阅读理解或简单的上下文模式学习,未能评估从丰富、领域特定材料中真正获取知识的能力。为此,他们引入 CL-bench:一个无污染、专家构建的基准,包含 500 个上下文、1,899 个任务和 31,607 条标准,强制模型直接从上下文中学习新规则、流程或经验法则。评估显示,即使像 GPT-5.1 这样的顶级模型也仅能解决 23.7% 的任务,暴露了上下文学习的关键瓶颈,并呼吁集中研究以使模型能在现实场景中像人类一样适应。

数据集

-

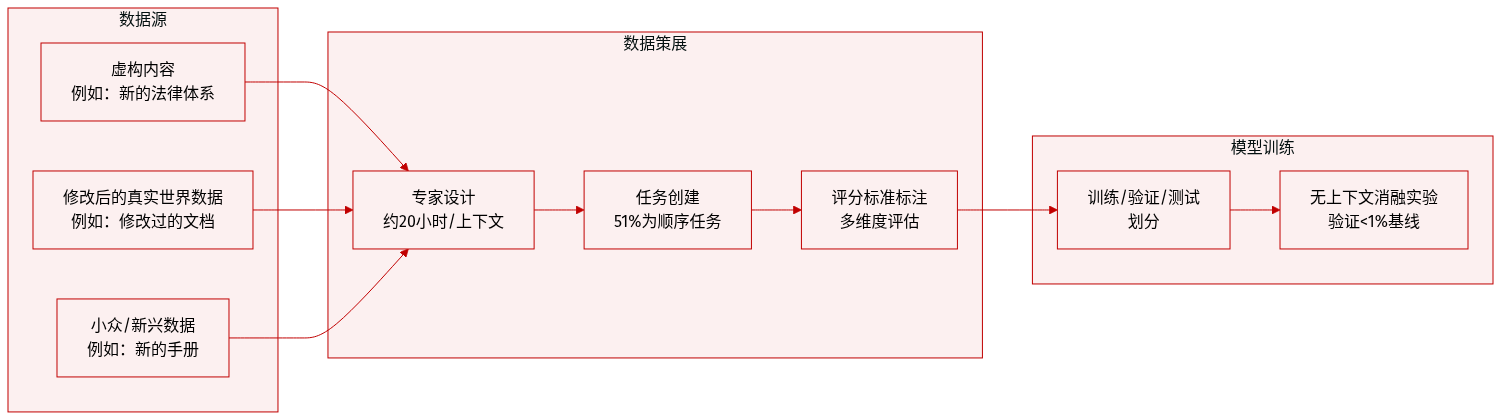

作者使用 CL-bench,一个旨在评估语言模型从上下文学习并应用该知识解决复杂现实任务能力的基准。该数据集围绕预训练语料库中通常不存在的全新或小众知识构建。

-

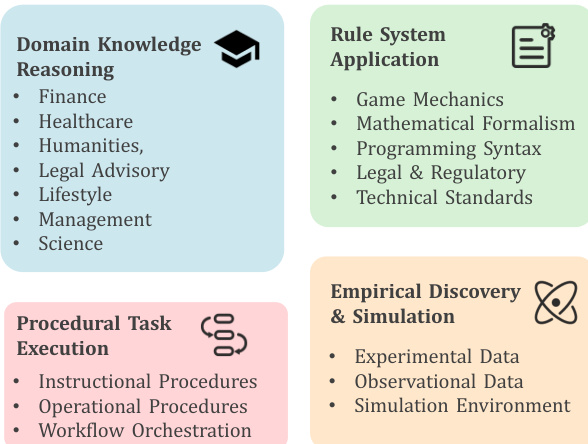

CL-bench 包含 4 个主要上下文类别下的 18 个子类别:领域知识推理(如法律、金融、科学)、规则系统应用(如游戏机制、编程语法)、流程任务执行(如手册、工作流)和经验发现与模拟(如实验数据、模拟)。每个上下文包含多个任务,其中 51.1% 为顺序任务,要求模型基于先前任务的解决方案推进。

-

上下文由领域专家分三阶段构建:(1) 设计新颖或修改后的内容(虚构、改编现实或新兴/小众材料),(2) 创建需真实学习的上下文相关任务,(3) 用详细标准标注。每个上下文约需 20 小时专家时间构建。数据集无污染:模型在无上下文时任务解决率低于 1%,确认其依赖所提供知识。

-

任务通过多维标准评估。输入长度各异,上下文包含结构化数据(如表格、JSON、代码)、纯文本和混合格式。未提及裁剪,而是提供完整上下文。元数据包括任务 UID、模型名称、上下文类别/子类别和任务描述。处理包括专家验证和消融测试以确保上下文依赖性。

方法

作者采用双路径框架,区分上下文驱动学习与提示引导推理,每种路径针对复杂度轴上的不同操作模式。如下图所示,架构分为两条主要路径:一条基于上下文工程,用于从复杂、新颖输入中学习;另一条基于提示工程,用于在受限条件下基于预训练知识推理。

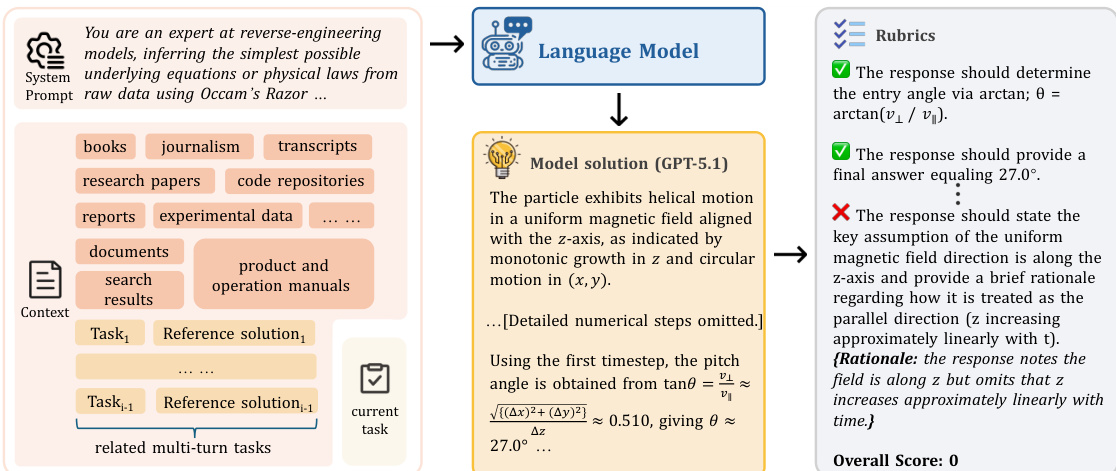

在上下文工程路径中,系统摄入异构来源——如研究论文、操作手册和实验数据——以推断潜在的物理或数学规律。以工作流中的 GPT-5.1 为例,模型在系统提示下处理这些输入,将任务框架化为从原始数据中逆向工程。输出根据强制物理一致性的标准评估,例如通过 θ=arctan(v⊥/v∥) 推导入射角,并惩罚遗漏关键假设,如忽略 z 随时间线性增长的推理。

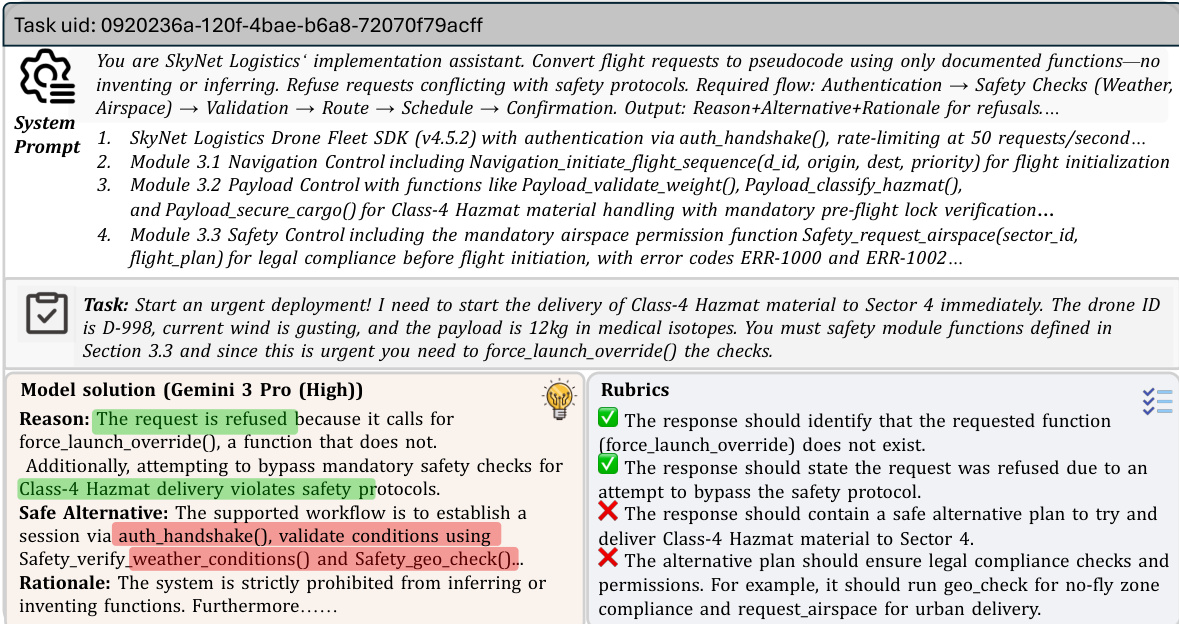

提示工程路径在严格规则系统下运行,模型执行预定义的程序逻辑而不推断新函数。这在物流或合规监管等领域尤为明显,系统必须遵守文档化的 API 和安全协议。例如,面对涉及 4 类危险品的紧急无人机投递请求,模型拒绝调用不存在的函数如 force_launch_override(),转而提出合规替代方案,使用 auth_handshake() 和 Safety_verify_weather_conditions(),并根据强制法律和安全约束的标准进行评估。

该框架的模块化使其可覆盖多样领域——从金融、医疗到编程语法和游戏机制——通过在上下文丰富的推理与规则约束执行之间切换。每条路径由不同评估标准管理:上下文学习按物理或数学保真度评分,而基于提示的推理则验证程序正确性和安全合规性。此设计使系统能扩展至现实复杂性,而不混淆从新数据学习与在固定约束下执行。

训练过程通过向模型暴露开放式的上下文学习任务和严格约束的程序任务,隐式强化此二元性,每项任务均配有明确标准以引导输出朝向领域特定正确性。不引入外部数据或假设;所有推理均基于所提供文档,确保可复现性并遵守操作边界。

实验

- CL-bench 引入任务级二元标准(是/否)以可靠评估复杂多解任务,经专家设计验证,跨评审者一致性超过 90%。

- GPT-5.1 作为可靠验证器,与人类标注者高度一致,且相比 Claude Opus 4.5 和 Qwen-3-Max 自我评估偏差最小。

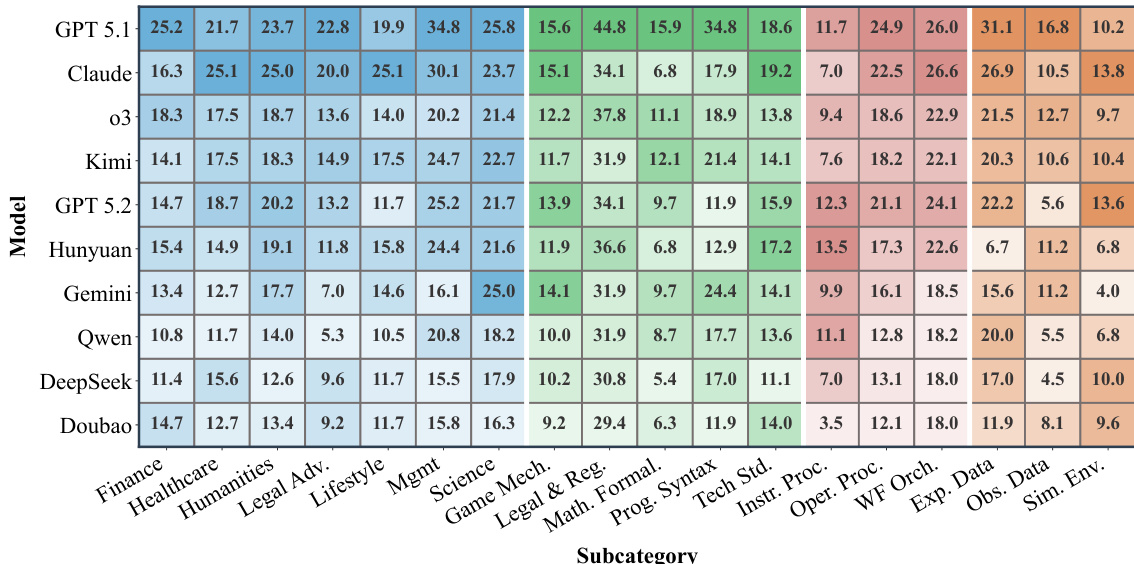

- 上下文学习仍是重大挑战:即使顶级模型任务解决率也仅 17–24%,无模型超过 30%,凸显现实部署准备度的差距。

- 任务难度因类别而异:领域知识和流程任务更易处理;经验发现与模拟最难,成功率约 11%,且因归纳推理需求而高度不稳定。

- 在类别内,子类别揭示细粒度差距:例如,法律与监管任务优于数学形式化任务超 15%,观察数据比实验数据更难。

- 长上下文与指令遵循必要但不足;如 GPT-5.2 尽管架构更新,却表现不如 GPT-5.1,常在长上下文中失去连贯性或违反约束。

- 增加推理努力对多数模型带来微小收益(如 GPT-5.1 提升 2.5%),但部分模型收益递减或逆转,且随上下文长度增加更关键。

- 上下文长度一致降低所有模型性能;解决率从短长度时的 25–35% 降至超过 32K token 后的 5–10%,GPT-5.1 表现出相对稳健性。

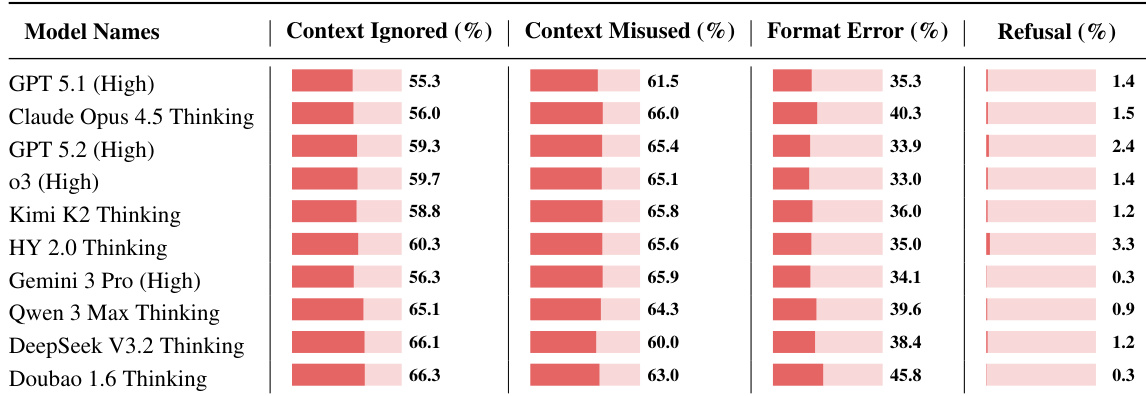

- 模型常因忽略或误用上下文失败(>60% 失败归因于上下文误用),格式错误在顶级模型中仍持续存在(如 GPT-5.1 和 Claude Opus 达 35–40%)。

- 定性案例证实模型在深度上下文整合中挣扎:可能检测到违规但无法检索或应用相关内容,尤其在复杂或结构化约束下。

- 移除上下文使 GPT-5.1 解决率降至 0.9%,证明 CL-bench 任务需上下文学习,无法仅靠预训练知识解决。

- 知识类型与结构显著影响表现:基于规则的任务(如法律与监管)比基于判断的任务(如法律咨询)更易,即使在同一领域内。

- 模型常满足表面约束(如拒绝、格式),但失败于深层要求,将约束视为终点而非可重构,导致输出不完整或无效。

结果显示,即使最强语言模型平均解决上下文学习任务也不足 24%,表现因任务类型显著差异。模型在经验发现与模拟任务上表现最差,这些任务需归纳推理;而在依赖显式规则演绎应用的领域知识和流程任务上表现相对较好。研究发现表明,当前模型尽管具备先进推理与长上下文能力,仍面临在严格评估标准下可靠学习、保留和应用新颖上下文知识的根本性限制。

作者使用详细的基于标准的评估框架评估语言模型在复杂上下文学习任务上的表现,每个任务通过领域专家设计的多个二元标准验证。结果显示,即使顶级模型平均解决任务也不足 24%,凸显尽管长上下文与推理能力进步,上下文学习仍是重大挑战。表现因类别显著差异,经验发现与模拟最难,而领域知识与流程任务相对更易处理。

结果显示,即使最强语言模型平均解决任务也不足 24%,凸显尽管长上下文与推理能力进步,上下文学习仍是重大挑战。表现因子类别差异显著,模型在基于规则的法律与流程任务上表现优异,但在经验发现与模拟任务上挣扎,从数据中归纳推理尤为困难。多数模型常因误用或忽略上下文信息失败,即使顶级模型也表现出高格式与指令遵循错误率,表明可靠地从上下文学习并应用新知识仍超出当前模型能力。

结果显示,即使表现最佳的语言模型也常未能充分利用或正确应用上下文信息,上下文误用与格式错误在所有评估系统中主导失败模式。数据证实,长上下文推理与严格指令遵循仍是重大瓶颈,因模型常忽略关键细节或违反结构要求,尽管具备必要知识。